Le programme de formation Big Data de la première semaine

Description

Dans cette formation, vous serez amenés à manipuler la distribution Cloudera (CDH 5.5+) En suivant des ateliers pratiques, vous serez en mesure de::

- Big Data: Cas d’utilisation, et écosystème

- Comprendre l’architecture et les services Hadoop: HDFS et YARN, innovations de la plateforme (TEZ,…)

- Manipuler les fichiers et les utilisateurs sur Hadoop

- Comprendre et écrire les Jobs Map/Reduce de Base

- Manipuler les Big Data Grâce aux langages évolués: Pig et Hive

- Ordonnancer et synchroniser les traitements, gérer et administrer les services hadoop

- Utiliser des entrepôts NoSQL de l’écosystème HDP: HBase et Solr

Volet pédagogique

Dans cette formation, vous serez amenés à manipuler la distribution Cloudera (CDH 5.5+)

En suivant des ateliers pratiques, vous serez en mesure de: :

- Utiliser la plateforme Cloudera CDH 5.5+ pour manipuler l’écosystème Hadoop

- Comprendre l’architecture de Hadoop, HDFS/YARN

- Manipuler le mode de commande / Console graphique pour gérer fichier/utilisateurs HDFS

- Comprendre, écrire et exécuter des jobs Map/Reduce de bas niveau

- Utiliser des langages de haut niveau comme Hive et Pig

- Administrer et gérer le cluster Hadoop ainsi que savoir orchestrer des Jobs de Calcul

- Manipuler des entrepôts NoSQL sur HDFS: HBase et Solr

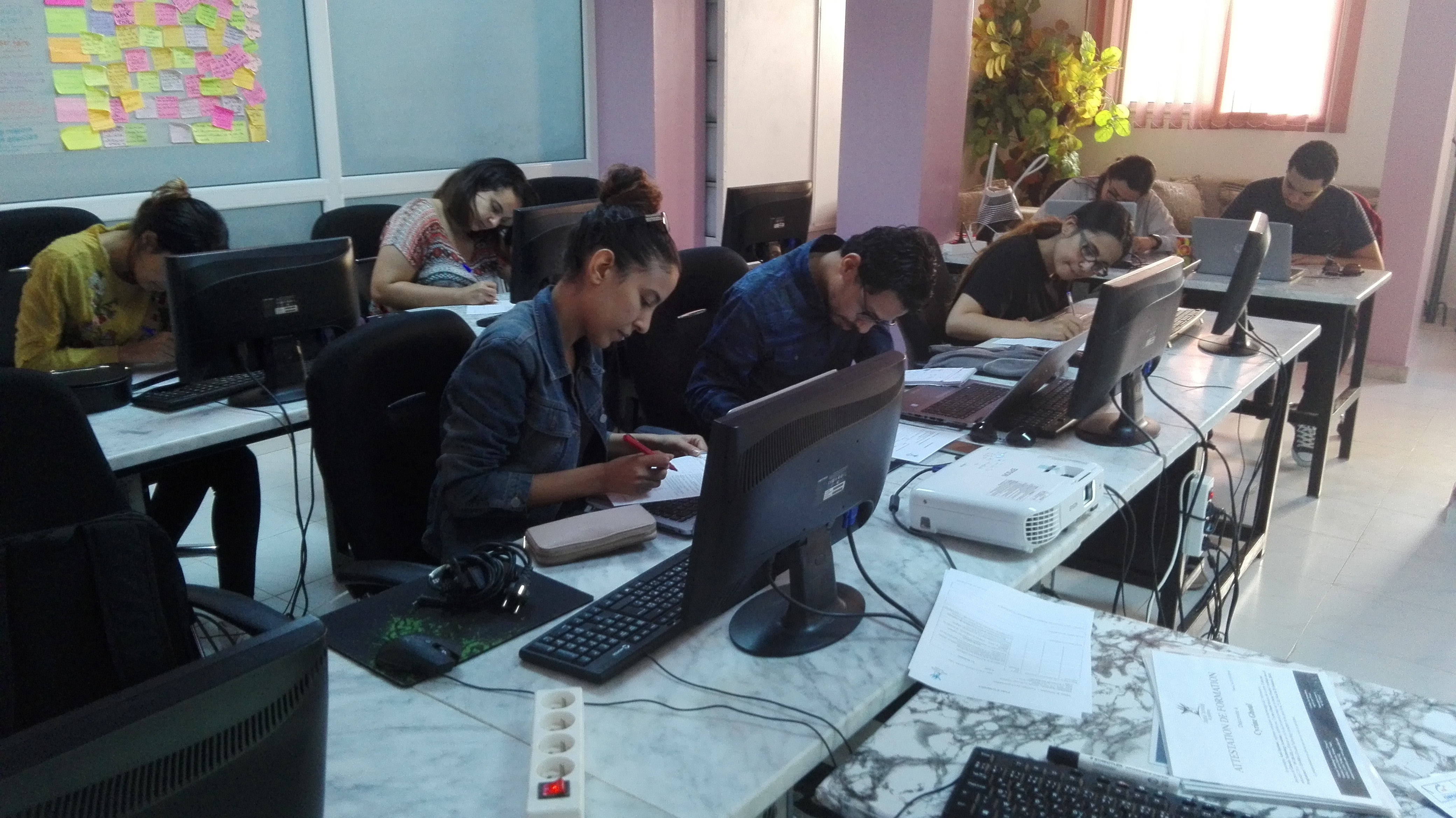

Méthodes pédagogiques

Le sujet est à 80% Pratique. Les 20% de théorie sont nécessaires pour expliquer l’architecture Hadoop et les concepts derrière L’architecture d’un cluster Hadoop, Map/Reduce, Hbase ou Solr

Volet technologique

Architecture de l'application

- Système de Fichiers/ Module d’allocation de ressources distribués

- Data Store NoSQL

- Map/Reduce

Technologie utilisée

- La distribution Hadoopde Cloudera (Briques 100% Opensource): (Virtual Box - nécessite des machines d’au moins 8 Go de RAM)

- Apache Hadoop(HDFS, YARN), Hue, Hive, Pig,HBase, Impala,Oozie, Solr.

- Mode de commande Linux , Java 1.8 ou 1.7

Pré-requis

- • Un minimum de connaissances en Java(la JVM surtout), Un minimum de connaissance en mode de commande Linux.

- Une bonne connaissance de langage SQL

Plan de formation

Jour 1 : Introduction

- Introduction Aux Big Data: Cas d’utilisation

- Hadoop : écosystème, algorithms, etc…

- Hadoop : Architecture / HDFS & YARN

- Atelier 1 : Configuration et installation de Hadoop Cloudera

- Atelier 2 : HDFS : Utiliser les commandes Hadoop et la console web Hue pour explorer le HDFS sur le système Hadoop.

Jour 2 : Calculs sur Hadoop

- MapReduce 2 YARN

- Atelier 3 : MapReduce (Language - Java) :Créer, Compiler et déboguer votre programme MapReduce sous Eclipse ; Exécutez votre programme MapReduce, surveillez les travaux et visualisez la sortie dujournal sous Hadoop.

- Langages de Scripting de Haut Niveau

- Atelier 4 : Hive : assurer la persistance des données dans le HiveMegaStore, lancer des requêtes avec HiveQL, Faire des agrégations, jointures, trie avec HiveQL

- Atelier 5 : Pig : Charger des données avec Pig, Création de schéma, de lecture et d'écriture de données, Accès aux champs d’un schéma avec Pig, Affichage des données

Jour 3:No SQL et Hadoop

- HBase: Base de données orientée colonnes sur HDFS

- TP : Manipulation HBaseshell

- TP: stocker résultat de jobs Hive sur Table HBase

- Solr: Le moteur d’indexation Apache

- Intégration pour indexation HDFS

- TP: indexer des données Hadoop via Apache Solr

Jour 4 :SQL sous Hadoop (All on one)

- Formats de données sous HDFS : Avro

- SQL Impala : SQL Interactif (requêtes SQL à faible latence)sous HBase et HDFS.

- Sqoop : Importation des données relationnelles vers HDFS

- Atelier 7 : Interrogation des données structurées et non structurées sur CLOUDERA : Cet atelier pemet d’exploiter les différents outils de Big data (Hive, SQL Impala, sqoop,HDFS, Avro) pour faire exactement la même chose que vous savez déjà faire (interrogation des BDR) mais avec CDH (Cloudera Distribution Including Apache Hadoop

Jour 5 : Administration d’un Cluster Hadoop (YARN).

- Cluster Hadoop : Architecture et Administration

- Vagrant : auto administration d’un cluster Hadoop

- Gestion des noeuds dans un cluster Hadoop

- TP Ajout, dé/re-commissionnment, suppression noeuds.

Le programme de formation Data science de la deuxième semaine

Les outils et environnements informatiques

Environnement :

|

Linux

|

Langage de développement :

|

Python 3.X

|

Plateforme Big Data :

|

Cloudera / Hortonworks

|

PlateformePython :

|

Anaconda

|

Machine Learning :

|

scikit-learn: pandas, NumPy, SciPy, and matplotlib..

|

Deep Learning :

|

Keras, TensorFlow

|

Jour 1: Data Science et Machine Learning

Introduction au Big Data

Qu’est-ce-que le Big Data ?

L’écosystème technologique du Big Data : Apache Hadoop

Travaux Pratiques : Manipulation d’un environnement Apache Hadoop avec Cloudera.

Introduction à la Data Science, le métier de Data Scientist

-

Le vocabulaire d’un problème de Data Science

-

De l’analyse statistique au machine learning

-

Overview des possibilités du machine learning

-

Les bases de Machine Learning

-

Le besoin de machine Learning

-

Comprendre machine Learning

-

Méthodes de Machine Learning

-

La boîte à outil du Data Scientist

-

Introduction aux outils : Anaconda, Jupyter Notebooks

-

Introduction au langage Python

-

Travaux pratiques :

-

Configurer l'environnement Anaconda Python

-

-

Jour 2: Data Science et Machine Learning

Les algorithmes de Machine Learning

-

Analyse supervisée

-

Analyse non supervisée

-

Classification / régression

-

La régression linéaire

-

Quelques rappels : fonction hypothèse, fonction convexe, optimisation

La construction de la fonction de coût

Méthode de minimisation : la descente de gradient

-

La régression logistique

-

Frontière de décision

-

Modélisation des variables quantitatives

-

La construction d’une fonction de coût convexe pour la classification

-

Naive Bayes

-

Le théorème de Bayes et la notion d’indépendance

-

Le modèle Naive Bayes par l’exemple

-

Machine Learning : Construction, réglage et déploiement de modèles

-

Qu’est-ce qu’un bon modèle ?

-

Cross-validation

-

Les métriques d’évaluation : precision, recall, ROC, MAPE, etc

-

Les pièges du machine learning

-

Overfitting ou sur-apprentissage

-

Biais vs variance

-

La régularisation : régression Ridge et Lasso

-

Jour 3:Pipeline de Machine Learning

Machine Learning avec Python, Pandas et Scikit-learn

-

Présentation de l’Ecosystème Python Machine Learning

-

NumPy et SciPy : manipuler des matrices ou tableaux multidimensionnels ainsi que des fonctions mathématiques opérant sur ces tableaux

-

Pandas : structures de données et opérations de manipulation de tableaux numériques et de séries temporelles

-

Matplotlib : librairie pour afficher les histogrammes des valeurs numériques :

-

Scikit-learn :librairie de Machine Learning en Python

-

Travaux pratiques :

-

Prise en main de NumPy et SciPy viaJupyter Notebooks

-

Prise en main de Pandas et Matplotlib via Jupyter Notebooks

-

Premier pas en Machine Learning avec Scikit-learnvia Jupyter Notebooks

-

Machine Learning: Data Preparation and Cleaning

-

Les types de données : catégorielles, continues, ordonnées, temporelles

-

Détection des outliers statistiques, des valeurs aberrantes

-

Stratégie pour les valeurs manquantes

-

Travaux Pratiques : Comment traiter les valeurs manquantes avec Python ?

-

Data Preparation and Cleaning avec avecScikit-learn (sklearn.preprocessing)

-

Machine Learning :Feature Engineering

-

Stratégies pour les variables non continues

-

Détecter et créer des variables discriminantes

-

Travaux Pratiques :

-

Identification et création des bonnes variables et réalisation d’un premier modèleavec Scikit-learn(sklearn.feature_extraction)

-

Machine Learning : Data Visualization

-

La visualisation pour comprendre les données : histogramme, scatter plot, etc

-

La visualisation pour comprendre les algorithmes : train / test loss, feature importance, etc

-

Travaux Pratiques :

-

Visualiser des données Machine Learning en Python avec Pandaset Matplotlib

-

Jour 4 : Machine Learningpar la Pratique

Naive Bayes Classification par la Pratique

-

-

GaussianNaive Bayes

-

Multinomial Naive Bayes

-

Travaux Pratiques :

-

Naive Bayes avec Python-Scikit-learn : “ Naive Bayes on the Titanic dataset”

-

LinearRegressionpar la Pratique

-

Simple LinearRegression

-

Basis Fonction basiques de la Régression

-

fonctions Polynomiales

-

fonctions Gaussiennes

-

Régularisation

-

Travaux Pratiques :

-

Création d’un modèle basé sur LinearRegressionavec Python pour la prédiction du prix du logement

-

Support Vector Machinespar la Pratique

-

Présentation de Support Vector Machines : Trouver des patterns fortement non linéaires.

-

Maximisation de la marge entre la frontière de décision

-

Choix d’un hyperplan séparateur dans un nouvel espace de combinaisonsnon linéaires entre les variables

-

Travaux Pratiques :

-

Prédiction du prix du logement à l'aide Support Vector Machines avec Python

-

Jour 5 : Machine Learning par la Pratique

Introduction aux méthodes ensemblistes

-

Le modèle de base : l’arbre de décision, ses avantages et ses limites

-

Présentation des différentes stratégies ensemblistes : bagging, boosting, etc

-

Travaux Pratiques "Retour sur le Titanic" :

-

Prédiction du prix du logement à l'aide del’arbre de décisionavec Python

-

Prédiction du prix du logement à l'aide de Random Forest avec Python

-

Apprentissage semi-supervisé

-

Les grandes classes d’algorithmes non supervisées :

-

Clustering(K-Means ,Hierarchical clustering ..ect)

-

Principal Component Analysis, etc

-

Travaux Pratiques

-

Clustering K-Means des stocks par corrélation des prix.

-

Neural Network and DeepLearning

-

Bases de l'apprentissage en profondeur et des réseaux de neurones

-

Optimisation d'un réseau neuronal avec propagation vers l'arrière

-

Construire des modèles d'apprentissage en profondeur avec Keras

-

Travaux Pratiques

-

Installation Keras avec Anaconda

-

Deep Learning House Price Prediction avec Keras.

-

Clustering K-Means des stocks par corrélation des prix.

Neural Network and DeepLearning

-

Bases de l'apprentissage en profondeur et des réseaux de neurones

-

Optimisation d'un réseau neuronal avec propagation vers l'arrière

-

Construire des modèles d'apprentissage en profondeur avec Keras

-

Travaux Pratiques

-

Installation Keras avec Anaconda

-

Deep Learning House Price Prediction avec Keras.

Nous contacter sur le 27 862 155 , 54 828 018, 71 866 142

Durée :

10 jours

Cours du jours :

De 9h à 14h

Merci de nous contacter via email sur le contact@ghazelatc.com ou bien sur le 54 828 100, 54 828 018, 71 866142

Facilité de paiement

Vous pouvez payer par facilité à savoir par chèque anti daté sur plusieurs mois

Vous êtes une entreprise :

Nous sommes à votre entière disposition pour vous fournir les documents nécessaires au vu de la déduction des frais de formation sur la TFP(Taxe à la Formation Professionnelle).

Vues

Vues